Nvidia的插件使得Docker容器GPU加速的可能

该供应商编写的一块已被执行网络媒体编辑,以消除产品推广,但读者应该注意到它可能会倾向于提交者的做法。

这是一个难题:你有深刻的学习软件,从GPU加速获益匪浅,在码头工人的容器包裹起来,准备去跨越数千个节点。但等待 - 因为他们,那么,在集装箱Docker容器的应用程序无法访问GPU。

好了,现在他们可以。Nvidia公司,用于GPU加速编程CUDA标准开发,是释放了泊坞生态系统,使GPU加速计算成为可能在容器中的插件。有了这个插件,在泊坞窗容器中运行的应用程序得到控制的访问到GPU通过多克尔自己的插件系统底层的硬件上。

我插在右

作为NVIDIA在博客中指出,早期的途径开发商试图解决该问题是安装在容器内Nvidia的GPU驱动程序,并将它们映射到外面的驱动程序。聪明的,因为这是解决办法,因为在里面的司机和外面必须是完全相同的版本并没有很好地工作。 “此要求大大减少这些早期的容器的便携性,破坏的多克尔的更重要的功能之一,”Nvidia称。

Nvidia的新方法 - 一个开源的泊坞窗插件,名为NVIDIA技术的码头工人 - 提供了一套驱动程序无关的CUDA图像的一个容器的内容,与坐骑CUDA的用户模式组件当容器是一个命令行包装一起推出。使用该GPU的图像泊坞窗,必须针对Nvidia的CUDA工具包建的,但Nvidia公司提供那些Docker容器为好。 Nvidia公司甚至提供了自动置备件的Ansible作用。

默认情况下,支持CUDA的容器使用所有可用的GPU,不过NVIDIA-泊坞窗提供了一些方法来限制应用程序只能使用特定的图形处理器。这派上用场,如果你已经建立了具有图形处理器阵列的系统和要指派特定的处理器具体工作。它还提供了云服务提供商自动油门当GPU的访问开始成为在云中托管容器的标准功能提供给容器GPU的数量土生土长的方式。

CUDA及其不满

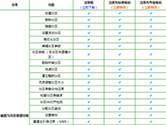

机器学习项目的一小部分已经开始提供应用程序与NVIDIA CUDA支持配备的Dockerfiles提前插件的1.0版本的。许多这些包都是熟悉的机器学习的用户:谷歌的TensorFlow,微软的CNTK,和长期行业标准的项目来自Caffe和Theano。

与NVIDIA-泊坞窗最大的缺点是,CUDA是一个专有的标准,而绝大多数GPU加速计算与CUDA完成。长期Nvidia的竞争对手AMD提出并推动其自身的GPUOpen标准,其目的不仅是让一个开源的一套方法为基于GPU计算的,但也有可能写出只需重新编译两个CPU和GPU执行软件相同的源。

苏公网安备32032202000432

苏公网安备32032202000432